Es un experimento mental que analiza la distinta percepción del tiempo entre dos observadores con diferentes estados de movimiento.

Esta paradoja fue propuesta por Einstein al desarrollar lo que hoy se conoce como la relatividad especial. Dicha teoría postula que la medida del tiempo no es absoluta, y que, dados dos observadores, el tiempo medido entre dos eventos por estos observadores, en general, no coincide, sino que la diferente medida de tiempos depende del estado de movimiento relativo entre ellos. Así, en la teoría de la relatividad, las medidas de tiempo y espacio son relativas, y no absolutas, ya que dependen del estado de movimiento del observador. En ese contexto es en el que se plantea la paradoja.

Esta paradoja fue propuesta por Einstein al desarrollar lo que hoy se conoce como la relatividad especial. Dicha teoría postula que la medida del tiempo no es absoluta, y que, dados dos observadores, el tiempo medido entre dos eventos por estos observadores, en general, no coincide, sino que la diferente medida de tiempos depende del estado de movimiento relativo entre ellos. Así, en la teoría de la relatividad, las medidas de tiempo y espacio son relativas, y no absolutas, ya que dependen del estado de movimiento del observador. En ese contexto es en el que se plantea la paradoja.

Formulación de la paradoja

En la formulación más habitual de la paradoja, debida a Paul Langevin, se toma como protagonistas a dos gemelos (de ahí el nombre); el primero de ellos hace un largo viaje a una estrella en una nave espacial a velocidades cercanas a la velocidad de la luz; el otro gemelo se queda en la Tierra. A la vuelta, el gemelo viajero es más joven que el gemelo terrestre.

De acuerdo con la teoría especial de la relatividad, y según su predicción de la dilatación del tiempo, el gemelo que se queda en la Tierra envejecerá más que el gemelo que viaja por el espacio a gran velocidad (más adelante se prueba esto mediante cálculo) porque el tiempo propio del gemelo de la nave espacial va más lento que el tiempo del que permanece en la Tierra y, por tanto, el de la Tierra envejece más rápido que su hermano.

Pero la paradoja surge cuando se hace la siguiente observación: visto desde la perspectiva del gemelo que va dentro de la nave, el que se está alejando, en realidad, es el gemelo en la Tierra (de acuerdo con la Invariancia galileana) y, por tanto, cabría esperar que, de acuerdo con los cálculos de este gemelo, su hermano en la Tierra fuese quien tendría que envejecer menos por moverse respecto de él a velocidades cercanas a la de la luz. Esto es, el gemelo de la nave es quien tendría que envejecer más rápido.

La paradoja quedaría dilucidada si se pudiese precisar quién envejece más rápido realmente y qué hay de erróneo en la suposición de que, de acuerdo con los cálculos del gemelo de la nave, es el gemelo terrestre quien envejece menos.

En la formulación más habitual de la paradoja, debida a Paul Langevin, se toma como protagonistas a dos gemelos (de ahí el nombre); el primero de ellos hace un largo viaje a una estrella en una nave espacial a velocidades cercanas a la velocidad de la luz; el otro gemelo se queda en la Tierra. A la vuelta, el gemelo viajero es más joven que el gemelo terrestre.

De acuerdo con la teoría especial de la relatividad, y según su predicción de la dilatación del tiempo, el gemelo que se queda en la Tierra envejecerá más que el gemelo que viaja por el espacio a gran velocidad (más adelante se prueba esto mediante cálculo) porque el tiempo propio del gemelo de la nave espacial va más lento que el tiempo del que permanece en la Tierra y, por tanto, el de la Tierra envejece más rápido que su hermano.

Pero la paradoja surge cuando se hace la siguiente observación: visto desde la perspectiva del gemelo que va dentro de la nave, el que se está alejando, en realidad, es el gemelo en la Tierra (de acuerdo con la Invariancia galileana) y, por tanto, cabría esperar que, de acuerdo con los cálculos de este gemelo, su hermano en la Tierra fuese quien tendría que envejecer menos por moverse respecto de él a velocidades cercanas a la de la luz. Esto es, el gemelo de la nave es quien tendría que envejecer más rápido.

La paradoja quedaría dilucidada si se pudiese precisar quién envejece más rápido realmente y qué hay de erróneo en la suposición de que, de acuerdo con los cálculos del gemelo de la nave, es el gemelo terrestre quien envejece menos.

Solución de la paradoja según la relatividad especial

A Einstein le costó aclarar esta paradoja unos cuantos años, hasta que formuló la relatividad general y demostró que, ciertamente, es el gemelo de la Tierra quien envejece más rápido.

Sin embargo, aunque Einstein resolvió la paradoja en el contexto de la relatividad general, la paradoja puede resolverse dentro de los límites de la teoría de la relatividad especial, como muestra este artículo.

Para dilucidar la aparente paradoja es necesario realizar los cálculos desde el punto de vista del gemelo que permanece en la Tierra y desde el punto de vista del gemelo viajero, y ver que las estimaciones de tiempo transcurrido coinciden examinadas desde ambos puntos de vista.

El cálculo desde el punto de vista del gemelo terrestre es rutinario y muy sencillo. El cálculo desde el punto de vista del gemelo viajero es más complejo porque requiere realizar cálculos en un sistema no inercial. A continuación, se presentan las predicciones de la teoría aplicadas a ambos gemelos y se prueba que los resultados coinciden, demostrando que la aparente paradoja no es tal.

A Einstein le costó aclarar esta paradoja unos cuantos años, hasta que formuló la relatividad general y demostró que, ciertamente, es el gemelo de la Tierra quien envejece más rápido.

Sin embargo, aunque Einstein resolvió la paradoja en el contexto de la relatividad general, la paradoja puede resolverse dentro de los límites de la teoría de la relatividad especial, como muestra este artículo.

Para dilucidar la aparente paradoja es necesario realizar los cálculos desde el punto de vista del gemelo que permanece en la Tierra y desde el punto de vista del gemelo viajero, y ver que las estimaciones de tiempo transcurrido coinciden examinadas desde ambos puntos de vista.

El cálculo desde el punto de vista del gemelo terrestre es rutinario y muy sencillo. El cálculo desde el punto de vista del gemelo viajero es más complejo porque requiere realizar cálculos en un sistema no inercial. A continuación, se presentan las predicciones de la teoría aplicadas a ambos gemelos y se prueba que los resultados coinciden, demostrando que la aparente paradoja no es tal.

Cálculo según el gemelo terrestre

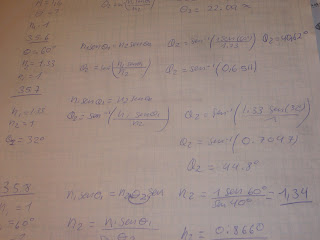

Por tanto, en el momento del encuentro de acuerdo con los cálculos del gemelo terrestre, él y su gemelo viajero habrán notado tiempos diferentes de viaje dados por:

Es sencillo comprobar que para cualesquiera valores de w, T1 y T2, el segundo tiempo es siempre menor que el primero:

Es sencillo comprobar que para cualesquiera valores de w, T1 y T2, el segundo tiempo es siempre menor que el primero:

y por tanto, el gemelo terrestre envejecerá más que el gemelo viajero.

Cálculo según el gemelo viajero

Finalmente para calcular la duración de la segunda etapa del viaje para ambos gemelos, pero haciendo los cálculos según el sistema de referencia del gemelo viajero, tenemos que seleccionar una forma de la métrica.

Resolución de la paradoja en relatividad general

Aunque la paradoja de los gemelos puede resolverse íntegramente dentro de la teoría especial de la relatividad, resulta interesante considerar el mismo problema desde el punto de vista de teoría de la relatividad general. Usando el enfoque de esa teoría más general, la parte del viaje en la que el gemelo viajero se mueve aceleradamente son percibidas por éste como si estuviera en el seno de un "campo gravitatorio efectivo" asociado a la aceleración, de acuerdo con lo postulado por el principio de equivalencia. Este punto de vista está bien representado en la solución que ofreció Einstein de la paradoja en 1918 dentro del marco de la teoría general.

Según el enfoque de la relatividad general la diferencia acumulada de tiempo entre los dos gemelos puede ser explicada mediante una dilatación gravitacional del tiempo. De acuerdo con la relatividad general, la relación entre los tiempos propios acumulados por dos observadores situados en diferentes puntos de un campo gravitatorio estático puede representarse por:

Según el enfoque de la relatividad general la diferencia acumulada de tiempo entre los dos gemelos puede ser explicada mediante una dilatación gravitacional del tiempo. De acuerdo con la relatividad general, la relación entre los tiempos propios acumulados por dos observadores situados en diferentes puntos de un campo gravitatorio estático puede representarse por:

Evidencia experimental

Contrariamente a lo que piensa la gente, la paradoja no es el hecho de que un gemelo envejezca más rápido que otro, sino en el razonamiento capcioso que sugería que los dos gemelos concluirían que es el otro quien envejecería más. Como se ha visto los cálculos de los dos gemelos concuerdan en que será el gemelo terrestre quien envejecerá más.

El hecho de que el tiempo transcurra de diferentes maneras para diferentes observadores, y que dos observadores puedan reencontrarse de nuevo en el mismo punto del espacio-tiempo habiendo envejecido uno menos que otro no constituye ninguna paradoja en teoría de la relatividad, sino que de hecho se trata de un hecho probado.

Contrariamente a lo que piensa la gente, la paradoja no es el hecho de que un gemelo envejezca más rápido que otro, sino en el razonamiento capcioso que sugería que los dos gemelos concluirían que es el otro quien envejecería más. Como se ha visto los cálculos de los dos gemelos concuerdan en que será el gemelo terrestre quien envejecerá más.

El hecho de que el tiempo transcurra de diferentes maneras para diferentes observadores, y que dos observadores puedan reencontrarse de nuevo en el mismo punto del espacio-tiempo habiendo envejecido uno menos que otro no constituye ninguna paradoja en teoría de la relatividad, sino que de hecho se trata de un hecho probado.